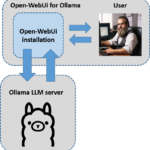

Ich möchte zu Beginn meines Artikels kurz beschreiben was Alpaca-LLaMA für ein Projekt ist. Dabei handelt es sich um ein Open-Source-Projekt, das darauf abzielt, eine lokale Version eines Chatbots auf Basis der GPT-3-Technologie zu erstellen und die Projektseite auf der Webseite der Standford Universität findet ihr hier Stanford Alpaca . Im Gegensatz zu anderen GPT-3-basierten Chatbots, die auf Cloud-Plattformen gehostet werden und eine Internetverbindung benötigen, läuft Alpaca-LLaMA auf fast jedem Computer ohne Internetverbindung. Wichtig ist aber damit die Antworten zügig kommen und eines der leistungsfähigeren zur Auswahl stehenden trainierten Neuronale Netze ausgeführt werden können das die CPU über 32+ Kerne verfügt und mindestens 64GB Ram verbaut sind. So ist der lokale Chatbot dann in der Lage, natürliche Sprache zu verstehen und auf Fragen des Benutzers zu antworten, die ihm gestellt werden. Alpaca-LLaMA sollte unter keinen Umständen für kommerzielle Anwendungen eingesetzt werden, wie zum Beispiel für den Kundensupport, die Produktbeschreibung oder die Erstellung von Texten. Denn rechtlich handelt es sich hier um eine Kopie des META LLaMA neuronalen Netzes, dass ohne das es META wollte im öffentlich zugänglichen Internet gelandet und somit frei war und für META verloren. So schreiben die Forscher zu diesem rechtlichen Sachverhalt folgendes auf der Projektseite:

We emphasize that Alpaca is intended only for academic research and any commercial use is prohibited. There are three factors in this decision: First, Alpaca is based on LLaMA, which has a non-commercial license, so we necessarily inherit this decision. Second, the instruction data is based on OpenAI’s text-davinci-003, whose terms of use prohibit developing models that compete with OpenAI. Finally, we have not designed adequate safety measures, so Alpaca is not ready to be deployed for general use.

Dennoch ist dieses Projekt ein vielversprechender Ansatz für die Entwicklung von Chatbots und Sprach-KI-Technologien, die unabhängig von Cloud-Plattformen betrieben werden können und bringt hoffentlich im Positiven die weltweite KI Forschung schneller voran.

Hier einmal die wesentlichen Punkte zu dem Alpaca-LLaMA Projekt zusammengefasst:

- Alpaca-LLaMA ist ein Open-Source-Chatbot, der auf der GPT-3-Technologie basiert und auf jedem Computer ohne Internetverbindung ausgeführt werden kann.

- Im Gegensatz zu anderen GPT-3-basierten Chatbots, die eine Internetverbindung benötigen und auf einer Cloud-Plattform gehostet werden, läuft Alpaca-LLaMA lokal auf dem Rechner.

- Der Chatbot ist in der Lage, natürliche Sprache zu verstehen und auf Fragen oder Anfragen zu antworten, die ihm gestellt werden.

- Alpaca-LLaMA kann für verschiedene Anwendungen eingesetzt werden, wie zum Beispiel für den Kundensupport, die Produktbeschreibung oder die Erstellung von Texten aber die rechtlichen Probleme bei einem kommerziellen Einsatz müssen dann geklärt werden.

- Der Chatbot kann auch als Werkzeug für kreative Schreibprojekte oder als personalisierter Schreibassistent verwendet werden.

- Die Entwickler von Alpaca-LLaMA betonen, dass ihre Technologie nicht als Ersatz für menschliche Autoren oder Schriftsteller gedacht ist, sondern als Werkzeug, um den Schreibprozess zu erleichtern und zu verbessern.

- Die Installation von Alpaca-LLaMA erfordert einige technische Kenntnisse und kann für unerfahrene Benutzer etwas kompliziert sein. Mit etwas Erfahrung im Bereich von z. B. Linux und einer schnellen Internetanbindung ist die Installation in ca. 30 Minuten erledigt.

- Alpaca-LLaMA ist ein vielversprechender Ansatz für die Entwicklung von Chatbots und Sprach-KI-Technologien und bringt hoffentlich die weltweite Forschung in diesem Bereich weiter voran.

Installation – Dalai auf Ubuntu (Linux)

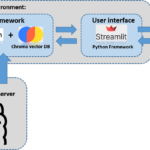

Für die Installation auf Ubuntu / Linux folgt man am besten der Installationsanleitung auf GitHub des folgenden Projektes:

Dalai Git Hub Projektseite: Git Hub – cocktailpeanut

Wird die Installation gestartet wie dort beschrieben, dann wird im HOME Verzeichnis des Users ein Ordner dalai angelegt. Leider hatte ich keinen Parameter gefunden den Pfad der Installation anzupassen bzw. frei zu wählen. So habe empfehle ich hier einen symbolischen Link anzulegen der auf ein großes und vorallem schnelles Laufwerk verweist.

Hinweis Hardware:

Wichtig ist, dass die CPU Leistungsfähig ist und ausreichend RAM 64GB+ zur Verfügung stehen. Die Aussage das ganze würde auch auf einem Raspberry Pi funktionieren streite ich nicht ab aus technischer Sicht aber ob es für den Nutzer eine Freude ist lasse ich einmal offen.

Hinweis Software Abhängigkeiten:

Wichtig ist das die Versionen von Python und Node.js jenen entsprechen wie auf der Projektseite beschrieben. Andernfalls kommt es zu Problemen und das Projekt wird nicht funktionieren.

Weiter steht schön auf der Projektseite beschrieben wie die verschieden großen neuronalen Netze herunter geladen werden können. Dazu muss der folgende Befehl ausgeführt werden mit den Namen der neuronalen Netze aufgeführt hinter den Befehl. Hier ein Beispiel um z. B. alle Alpaca Netze einzurichten die dann in etwa 74 GB auf dem Ziellaufwerk belegen werden.

Befehl: npx dalai alpaca install 7B 13B 30B 65B

Jetzt ist es so, dass das Herunter laden der Netze etwas Zeit in Anspruch nimmt. Möchte man solange nicht warten oder Startet erst einmal nur mit den Netzen 7B und 13B und lädt dann ein paar Tage später die Netze 30B und 65B herunter kann es passieren, dass wenn der Befehl ein zweites Mal ausgeführt wird die bereits herunter geladenen Netze 7B und 13B gelöscht werden. Daher immer wenn ein Netz erfolgreich herutner geladen wurde dieses in einem extra Ordner sichern. Da es für mich hier um einen kleinen Fehler im Downloader handelt wird das Verhalten auch bei den llama Befehl sich ähnlich verhalten.

Befehl: npx dalai llama install 7B 13B 30B 65B

Natürlich ist ausreichen Platz auf dem Ziellaufwerk erforderlich sowie auf dem BackUp Laufwerk. Es kommen hier schon sehr schnell in Summe 400GB+ zusammen.

Hinweis Netze sichern: Wie beschrieben immer alle erfolgreich herunter geladenen Netze ob alpaca oder llama in einem extra BackUp Ordner sichern damit diese nicht ausversehen verloren gehen.

Ist alles eingerichtet und installiert dann kann Dalai als Framework gestartet werden. Auch dieser Befehl ist bei der oben genannten Installationsanleitung sauber aufgeführt.

Dalai ausprobieren

Auf der Projekt Seite der Standford University gibt es eine live Demo Seite damit jeder Dalai mit den neuronalen alpaca und llama Netzen einmal ausprobieren kann. Diese Demo Seite ist über die folgende URL erreichbar.

Demo Dalai Testseite: https://crfm.stanford.edu/alpaca/

Im Menü der Web-Oberfläche kann dann das neuronale Netz direkt ausgewählt werden welches man nutzen möchte. Also z. B. alpaca7B oder eben alpaca30B.

Wird das Abfragefenster wie im Bild oben gezeigt angezeigt dann kann man an der Stelle PROMT seine Frage stellen. Hier empfehle ich dies auf Englisch zu machen auch wenn gleich nach dem META Paper auch weitere Sprachen wie Deutsch funktionieren werden. Die besten Ergebnisse wird man wohl mit der Englishen Sprache erreichen. Auch ist es möglich Fragen zu stellen wie bei ChatGPT in der folgenden Form: “List 10 points that led to the development of the internal combustion engine.” Dann erhält man eine Antwort von dem alpaca.30B Netz in diesem Fall die Vergleichbar ist mit der von ChatGPT.

Hier jetzt die beiden Antworten im Vergleich die die beiden Netze geliefert haben.

Dalai Projekt – Alpaca 30B – Antwort:

- The 10 key events leading up to the invention and successful deployment of an internal-combustion engine are as follows:

- The discovery by John Cugnot, a French inventor who built what is believed to be one of the first self propelled vehicles using steam power.

- The development of gasoline engines by Samuel Morey (US), Etienne Lenoir(France), and Gottleib Daimler (Germany).

- Otto’s four-stroke engine, which was an improvement on previous designs that could only run in two cycles.

- Rudolf Diesel’s development of a compression ignition engine to be used for power generation applications using coal dust as fuel.

- Karl Benz and Gottleib Daimler’s work with the automobile industry, which led to the commercialization of internal combustion engines in cars

- The introduction by Henry Ford of mass production techniques that enabled a huge increase in the number of vehicles produced using ICE technology.

- Robert Goddard’s development and demonstration of liquid-fueled rocketry, which used an engine similar to those found inside internal combustion engines

- The advent of hybrid electric cars, such as Toyota Prius in the late nineties that were able to utilize both petrol or diesel powered ICEs and battery storage for energy.

- Recent improvements by car manufacturers like Volvo who have committed themselves to switching from traditional internal combustion engines (ICE) towards electric vehicles over time

- The development of hydrogen fuel cells, which are beginning to be used in place of ICEs due their greater efficiency and cleaner emissions.

Chat GPT – Antwort:

- Discovery of the principle of combustion: The concept of combustion dates back to ancient times, but it was not until the 17th century that the principle of combustion was fully understood.

- Development of the steam engine: The steam engine was the first significant step towards the development of the internal combustion engine. It showed that energy could be harnessed and converted into motion.

- Early experiments with gas engines: In the early 19th century, inventors began to experiment with gas engines that used coal gas or other gaseous fuels to power internal combustion engines.

- Invention of the spark plug: The spark plug was invented in the 1860s, and it allowed for more efficient combustion in internal combustion engines.

- Development of the four-stroke cycle: The four-stroke cycle was developed in the 1870s, and it became the basis for most modern internal combustion engines.

- Improvements in fuel injection: The development of fuel injection systems in the early 20th century allowed for more precise control of fuel delivery, resulting in more efficient combustion.

- Use of gasoline as a fuel: Gasoline became the preferred fuel for internal combustion engines in the early 20th century due to its high energy density and availability.

- Advancements in metallurgy: Improvements in metallurgy in the 20th century allowed for the development of stronger, more durable engine components.

- Use of turbochargers and superchargers: Turbochargers and superchargers were developed in the early 20th century, and they allowed for more power to be extracted from internal combustion engines.

- Advancements in electronics and computer technology: In recent years, the use of electronic controls and computer technology has allowed for even more precise control of internal combustion engines, resulting in increased efficiency and performance.

Zusammenfassung

Ich kann jetzt nicht sagen, dass ich persönlich wenn ich mich als Anwender verstehe von dem Dalai Projekt wahnsinnig begeistert bin. Wobei es hier gilt zwei Blickwinkel zu betrachten. Einmal den wissenschaftlichen Blick auf dieses Projekt und den damit verbundenen Möglichkeiten. Das ist natürlich großartig und sehr spannend wie das Projekt die Forschung an AI Chat Bots weiterbringen wird. Als Anwender würde ich mir immer den OpenAI ChatGPT Plus Account holen wenn es darum geht solch ein Werkzeug professionell für die Arbeit zu nutzen. Aber auch dann gilt das Thema Datenschutz und welche Informationen teile ich mit OpenAI sich stets zu überlegen. Denn auch hier kann es ganz schnell Herausforderungen mit dem Datenschutz geben. Daher ist das Dalai Projekt sicher großartig hier selber einmal etwas auszuprobieren, mit dieser unglaublich spannenden Technik lokal zu arbeiten und die Datenhoheit behalten zu können.

Hallo, ich habe ihre Anleitung befolgt und bekomme im letzten Schritt leider immer folgende Meldung im Terminal: bash <(wget -qO-…

Hi Dennis, vielen Dank für den Hinweis, ich habe die URLs angepasst so das diese wieder gehen. Ich bin gespannt…

Ich weiss, es ist noch im Aufbau. Aber hier ist ein Broken Link: https://www.ai-box.eu/smurf_training_data_small.zip Freue mich drauf, die ganze Serie…