In den letzten Jahren hat künstliche Intelligenz, insbesondere seit dem Launch von ChatGPT (OpenAI) im November 2022, enorm an Bedeutung gewonnen. Ich hatte mitte März 2024 mit einem Gründer eines Startups ein interessantes Gespräch der mir erklärte das seine Kunden aus dem Mittelstand KMU die großen Anbieter von Künstliche-Intelligenz-as-a-Service” (AIaaS) oder “Natural-Language-Processing-as-a-Service” (NLPaaS) meiden aus Sorge ihr Firmen-Wissen zu verlieren. Dabei kann der Einsatz von KI-Technologien wie ChatGPT auch für kleinere und mittelständische Unternehmen äußerst vorteilhaft sein. Dabei geht es nicht nur um die Effizienzsteigerung der eignen Prozesse, sondern auch um die Einhaltung von Datenschutzrichtlinien, EU AI Act und die Vermeidung von Datenlecks nach außen.

Die Anforderungen im eigenen Unternehmen vor Ort selber verschiedene OpenSource Sprachenmodelle (LLMs) im Unternehmen bereitzustellen ohne das eigene Netzwerk verlassen zu müssen sind mittlerweile sehr niedrig.

Effiziente Nutzung von ChatGPT im KMU Umfeld

Mittelständische Unternehmen können on-prem ChatGPT Lösungen in verschiedenen Bereichen einsetzen, um ihre Effizienz zu steigern und Ressourcen zu sparen. Hier sind einige der Möglichkeiten:

1. Recherche erleichtern:

ChatGPT Lösungen können bei der Ideenfindung und Trendanalyse unterstützen, indem die Anwendung basierend auf Kundenfeedback und aktuellen Trends Vorschläge und Anregungen liefert.

2. Marketing und Content-Erstellung:

Durch die Kombination menschlicher Kreativität mit den Sprachverarbeitungsfähigkeiten von LLMs können Unternehmen hochwertige Inhalte für Marketingzwecke generieren, wie beispielsweise Social Media Posts, Newsletter und Rundmails. Dabei kann auf das Alter, die typische Sprache der Zielgruppe etc. individuell eingegangen werden. Kurz gesagt aus einem Textbaustein können automatisch für verschiedene Zielgruppen passende Texte generiert werden.

3. Automatisierter Kundensupport:

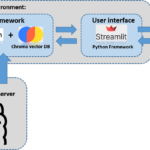

Chat-Lösungen können als ein virtueller Kundensupport-Agent eingesetzt werden, der rund um die Uhr Fragen beantwortet, Probleme löst und sogar Produkte empfiehlt. Dadurch können Unternehmen den Kundensupport entlasten eine höhere Qualität erreichen. Allerdings ist solch eine Lösung schon wieder deutlich aufwändiger umzusetzen da die Qualitätssicherung der Texte automatisiert noch nicht ganz so einfach möglich ist. So muss ein Groundig (Firmen / Produkt spezifisches Wissen) des zugrunde liegenden Sprachenmodells erfolgen um nicht z. B. Produkte der Konkurenz zu bewerben. Indem das Sprachmodell mit firmenspezifischem Wissen “gegroundet” wird, kann es zuverlässigere und maßgeschneiderte Antworten liefern, die den spezifischen Anforderungen und Bedürfnissen des Unternehmens entsprechen.

4. Unterstützung im Personalwesen und der Entwicklung:

ChatGPT kann Fragen von Bewerbern beantworten, Informationen über offene Stellen bereitstellen und sogar Schulungsmaterial für Mitarbeiter liefern. Hier muss aber unbedingt beachtet werden welche Vorgaben in Europa der EU AI Act vorgibt bei der Verarbeitung von Personen bezogenen Daten wie diese z. B. im Bewerbungsprozess von der Personalabteilung verarbeitet werden.

5. Schnelle Datenanalyse:

Durch die Analyse großer Datenmengen können LLMs Trends identifizieren und wertvolle Erkenntnisse in der Marktforschung liefern. So können automatisiert Sentiment-Analysen auf Basis der Kommunikation mit Kunden automatisiert durchgeführt werden. Der große Vorteil ist hier das die Analyse-Qualität immer konstant bleibt und nicht von der Tagesleistungskurve eines Menschen abhängt. Unternehmen können somit die Qualität ihrer Analysen steigern, Kosten und Ressourcen bei der Beauftragung externer Marktforschungsunternehmen einsparen bzw. die eigenen Mitarbeiter für komplexere Tätigkeiten einsetzen.

Datenschutz und Sicherheit gewährleisten

Die On-Premise-Nutzung der großen Sprachenmodelle ermöglicht es Unternehmen, die Kontrolle über ihre Daten zu behalten und Datenschutzrichtlinien strikt einzuhalten wenn diese Fähigkeiten im Unternehen vorhanden sind. Das ist möglich indem die Daten intern bleiben und nicht an externe Server die eventuell noch in nicht EU Ländern stehen gesendet werden, minimieren Unternehmen das Risiko von Datenlecks und schützen sensible Informationen vor unbefugtem Zugriff. Allerdings möchte ich hier ergänzen das die gängigen Cloudanbieter eine sehr hohe Sicherheit der Daten sowei Kommunikation bereitstellen wenn die Umgebungen vom Kunden entsprechend aufgesetzt werden.

On-Prem Lösungen für Large Language Modelle

In diesem Abschnitt möchte ich ein paar Lösungen aufzählen die es ermöglichen Sprachenmodelle in der eigenen Firma bzw. auf der eigenen Hardware laufen zu lassen so das diese im Unternehmen zur Verfügung stehen.

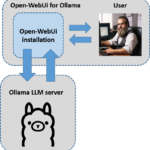

Ollama (habe ich persönlich ausprobiert)

Ollama ist eine Lösung, die es sehr einfach macht, leistungsstarke Sprachmodelle auf dem eigenen Computer auszuführen. Das kann ein aktuelles MAC Book Pro sein oder bei stärkerer Nutzung auch eine Workstation mit mehreren GPUs. Dabei müssen Sie sich nicht auf Cloud-Dienste oder entfernte Server verlassen. Sie können Ollama auf Mac OS und Linux nutzen und auch auf Windows. Ollama unterstützt eine Reihe von Modellen, wie LLaMA-2, uncensored LLaMA, CodeLLaMA, Falcon, Mistral und andere. Sie können diese Modelle mit wenigen einfachen Befehlen installieren und ausführen. Ollama ermöglicht es Ihnen, das Potenzial lokaler Sprachmodelle für Ihre eigenen Projekte zu nutzen. Ollama funktioniert auch mit Docker, sodass Sie Sprachmodelle in einem verteilten System (Kubernetes) bereitstellen und sie Ihren Anwendungen zur Verfügung stellen können.

URL: https://ollama.com/

Liste der verfügbaren LLM Modelle: https://ollama.com/library

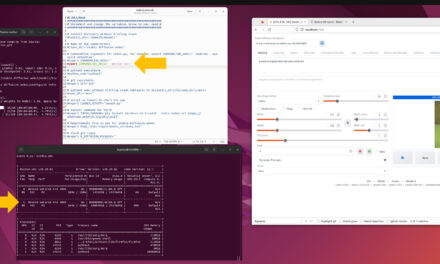

Oobabooga Text generation web UI (habe ich persönlich ausprobiert)

Oobabooga Text-Generation-WebUI ist ein benutzerfreundliches, Open-Source-Textgenerierungstool, das es ermöglicht verschiedene LLMs auf dem eignen Rechner laufen zu lassen um mit diesen zu interagieren. Darüber hinaus bietet es auch eine API Schnittstelle an um auch Texte generieren zu können ohne die Angebote der großen Dienste nutzen zu müssen. Diese vielseitige Software kann für verschiedene Anwendungen wie kreatives Schreiben, Chatbot-Entwicklung, Inhalteerstellung und sogar Sprachübersetzung verwendet werden, was sie zu einem unschätzbaren Werkzeug für Einzelpersonen und Unternehmen macht.

URL: https://github.com/oobabooga/text-generation-webui

LocalAI (nicht persönlich ausprobiert)

LocalAI ist eine kostenlose, Open-Source-Alternative zu OpenAI. Es fungiert als ein Ersatz für die REST-API von OpenAI und ist kompatibel mit den Spezifikationen der OpenAI-API für lokale Inferenz. Mit LocalAI können Sie LLMs betreiben, Bilder und Audio (und mehr) lokal oder vor Ort mit handelsüblicher Hardware generieren, und es unterstützt verschiedene Modellfamilien. Es erfordert keine GPU.

URL: https://github.com/mudler/LocalAI

Nvidia – Chat with RTX (nicht Open Soource und nicht persönlich ausprobiert)

“Chat with RTX” ist eine benutzerfreundliche Demo-App, die es dir ermöglicht, ein GPT (Großes Sprachmodell) nach deinen eigenen Vorlieben anzupassen. Dieses Modell kann auf deine persönlichen Inhalte wie Dokumente, Notizen und andere Daten zugreifen. Dank der Kombination von RAG (Retrieval Augmented Generation), TensorRT-LLM und RTX-Beschleunigung kannst du innerhalb kürzester Zeit personalisierte Antworten erhalten.

Das Beste daran? Alles wird lokal auf deinem Windows RTX-PC oder deiner Workstation ausgeführt, was nicht nur für schnelle Ergebnisse, sondern auch für maximale Sicherheit sorgt. Mit “Chat with RTX” bist du immer einen Schritt voraus!

URL: https://www.nvidia.com/de-de/ai-on-rtx/chat-with-rtx-generative-ai/

LM Studio (nicht Open Sorce und nicht persönlich ausprobiert)

LM Studio ist ein praktisches Tool, um Open-Source-LLMs auf Ihrem Desktop zu installieren und zu testen. Obwohl LM Studio selbst nicht Open Source ist, nutzt es die beliebte llama.cpp-Bibliothek. Die Nutzungsbedingungen verbieten Modifikationen, Weiterverteilung und kommerzielle Nutzung von LM Studio, und Änderungen dieser Bedingungen treten erst nach einer 30-tägigen Benachrichtigungsfrist in Kraft.

LM Studio ist benutzerfreundlich und für Windows und Mac verfügbar, eine Linux-Version ist in Arbeit. Dabei unterstützt LM Studio ganz verschiedene Sprachenmodelle Modelle, die mit der ggml-Tensorbibliothek des llama.cpp-Projekts kompatibel sind.

Die passende Hardware

Ich hatte bereits geschrieben das die Anforderungen gar nicht mehr so groß sind LLMs lokal im eigenen Firmennetzwerk laufen zu lassen. So kann schon ein einzelner Arbeitsplatzrechner wie ein MAC Book Pro für den ersten Kontakt reichen oder Hardware von der Stange bzw. Discounter. Ich möchte hier ein paar Beispiele aufzeigen die von der Leistung reichen um die ersten Versuche zu starten.

Hinweis: Ideal ist immer wenn die NVIDIA RTX Grafikkarten über mindestens 24GB Ram verfügen. Meine persönliche Empfehlung ist Ubuntu als Betriebssystem einzusetzen oder eben MAC OS X.

Workstation Ryzen 9 5900X – RTX 4090

Dieses System eignet sich besonders für anspruchsvolle Modellierungs- und Animationsaufgaben in Autodesk 3ds Max, Autodesk Maya und Cinema 4D aber auch kleinere OpenSource Sprachenmodelle lokal zu betreiben.

Preis: ca. 3.900,- €

URL: https://www.mifcom.de/workstation-ryzen-9-5900x-rtx-4090-id18184

14″ MacBook Pro

Preis: ca. 6.900,- €

BIG BOSS Xeon W7-2475X – RTX 4090 Quad

Wassergekühlte BIG BOSS-Systeme bieten Dir maximale Performance in allen professionellen Anwendungen. Diese Konfiguration mit seinen vier NVIDIA 4090 Grafikkarten bietet ausreichend Speicher auch größere Modelle parallel zu betreiben.

Preis: ca. 18.500,- €

URL: https://www.mifcom.de/big-boss-xeon-w7-2475x-rtx-4090-quad-id19652

BIG BOSS Ryzen TR PRO 7995WX – 7x RTX 6000 ADA

Diese BIG BOSS Konfiguration mit seinen sieben wassergekühlte NVIDIA RTX 6000 ADA Grafikkarten ist ideal für Anspruchsvolle Anwendungen auch in die Richtung in das Thema fine tuning von LLMs einzusteigen.

Preis: ca. 90.000,- €

URL: https://www.mifcom.de/big-boss-ryzen-tr-pro-7995wx-7x-rtx-6000-ada-id21172

Fazit: Die richtige Balance finden

Es ist wichtig zu betonen, dass Lösungen auf basis der großen Sprachenmodelle kreative menschliche Arbeitskräfte ersetzen soll, sondern vielmehr als Ergänzung für diese gesehen werden sollten. So können sich wiederholdende Aufgaben automatisiert werden oder eben Textvorschläge generiert werden die die Arbeit der Mitarbeiter unterstützt und wenn richtig eingesetzt deutlich beschleunigen. Unternehmen sollten darauf achten, dass die generierten Informationen von ihren gut ausgebildeten Mitarbeitern überprüft werden, um die Richtigkeit und Qualität zu gewährleisten. Insgesamt bietet die On-Premise-Nutzung von LLM unterstützen Anwendungen und Prozessen eine Vielzahl von Möglichkeiten für mittelständische Unternehmen, um ihre Effizienz zu steigern, Ressourcen zu sparen und die Kundenzufriedenheit zu verbessern.

Hallo, ich habe ihre Anleitung befolgt und bekomme im letzten Schritt leider immer folgende Meldung im Terminal: bash <(wget -qO-…

Hi Dennis, vielen Dank für den Hinweis, ich habe die URLs angepasst so das diese wieder gehen. Ich bin gespannt…

Ich weiss, es ist noch im Aufbau. Aber hier ist ein Broken Link: https://www.ai-box.eu/smurf_training_data_small.zip Freue mich drauf, die ganze Serie…