Stability AI, das innovative Startup hinter der faszinierenden Bild-KI Stable Diffusion, hat kürzlich ein aufregendes KI-Modell namens Stable Video Diffusion enthüllt. Dieses Modell ermöglicht es euch, mithilfe einfacher Bildbeschreibungen beeindruckende Videoclips zu erstellen – und das alles in einem Handumdrehen!

Genau wie sein Vorgänger, der auf statische Bilder spezialisierte Vorläufer, funktioniert das Stable Video Diffusion-Modell auf eine einzigartige Weise. Ihr gebt dem Modell ein Bild mit der Szene die als Video dargestellt werden soll und die KI zaubert euch darauf basierend einen komplett fertigen Videoclip der aktuell leider nur ca. 4 Sekunden lang ist. Das ist nicht nur KI in Aktion die ihr hier erleben könnt, das ist ein weiterer Schritt in die Richtung Kreativität auf Knopfdruck!

Was Stability AI als Startup besonders auszeichnet, ist ihre fortschrittliche Herangehensweise an Transparenz. Das Startup setzt seine Tradition fort und stellt nicht nur den Code, sondern auch die Modellgewichte für die Ausführung des Stable Video Diffusion-Modells frei zur Verfügung. Dieser offene Zugang unterscheidet Stability AI deutlich von anderen Playern wie OpenAI, die ihre bahnbrechenden Forschungsergebnisse zunehmend hinter verschlossenen Türen halten und damit auch den Nährboden bereiten wie dies jetzt erst mit Q* so passiert ist.

Für alle Kreativköpfe da draußen bietet Stability AI eine erfrischende Möglichkeit, in die Welt der KI-gesteuerten Videoproduktion einzutauchen. Also, lasst eurer Fantasie freien Lauf und erlebt, wie die Zukunft der Kreativität und Technologie Hand in Hand geht – dank Stable Video Diffusion von Stability AI!

Einschränkungen:

Aktuell ist das Modell für die Forschung gedacht und es gibt viele Einschränkungen bei der Nutzung. Dennoch macht es Spaß die Möglichkeiten auszuprobieren.

- Die Videos die generiert werden sind relativ kurz und dauern in der Regel kürzer als 4 Sekunden.

- Das Modell ist nicht dafür gedacht perfekte Fotorealistische Bilder zu erzeugen.

- Häufig werden durch das Modell Videos ohne Bewegung oder sehr langsamen / statischen Kamerabewegungen erzeugt.

- Es ist nicht möglich das Modell mit einem Text-Prompt anzusprechen. Es muss ein Bild als Eingangsparameter übergeben werden.

- Text der lesbar ist kann nicht durch das Modell generiert bzw. dargestellt werden.

- Menschen mit ordentlichen Gesichtern werden nicht richtig generiert.

- Die Bilder werden häufig mit Verlusten durch den Autocodierungsteil des Modells generiert.

Installation – Ubuntu System:

Wenn ich eine neue Software ausprobiere installiere ich immer alles in einer eigenen separaten virtuellen Anaconda Umgebung auf meinem Linux System. So werde ich auch hier erst einmal damit starten eine Anaconda Umgebung aufzusetzen. Wie ihr Anaconda auf eurem Ubuntu System installieren könnt erfahrt ihr hier auf meinem Blog. Stability AI hat auf GitHub alles veröffentlicht und dort könnt ihr noch einiges mehr nachlesen.

GitHub URL: https://github.com/Stability-AI/generative-models

Jetzt wird aber zunächst einmal die Umgebung angelegt. Dazu bitte den folgenden Befehl ausführen.

Befehl: conda create -n StableVideoDiffusion

Nach dem die Umgebung angelegt wurde wird diese nun aktiviert. Zum Aktivieren dieser frisch angelegte virtuelle Umgebung führt ihr den nachfolgenden Befehl aus.

Befehl: conda activate StableVideoDiffusion

Als nächstes wird das Stable Video Diffusion Projekt von GitHub herunter geladen. Ich empfehle es im Home-Verzeichnis des aktuellen Users zu installieren.

Befehl: cd ~

Befehl: git clone https://github.com/Stability-AI/generative-models.git

Jetzt wechselt ihr bitte in das Verzeichnis generative-models das nach dem clonen des Repositories angelegt wurde.

Befehl: cd generative-models

Jetzt wird über die requirements alles an Software in die virtuelle Umgebung installiert was noch benötigt wird.

Befehl: pip3 install -r requirements/pt2.txt

Nach dem die Installation abgeschlossen ist bitte noch den folgenden Befehl ausführen.

Befehl: pip3 install .

Jetzt ist eigentlich alles soweit eingerichtet und die Modelle müssen noch herunter geladen werden die benötigt werden um die Videos überhaupt generieren zu können. Diese findet ihr über die beiden nachfolgenden Links auf Huggingface.

Hier immer die beiden Dateien mit der Endung safetensor herunter laden.

URL SVD: https://huggingface.co/stabilityai/stable-video-diffusion-img2vid/tree/main

URL SVD_XT: https://huggingface.co/stabilityai/stable-video-diffusion-img2vid-xt/tree/main

Nach dem die vier Dateien mit der Endung safetensor herunter geladen sind müssen diese in ein Verzeichnis checkpoints im Ordner generative-models abgelegt werden. Legt also einen Ordner mit genau diesem Namen an.

Jetzt geht ihr in den Ornder generative-models/scripts/demo und kopiert die Python-Datei video_sampling direkt in den Ornder generative-models. Jetzt führt ihr diese innerhalb eurer virtuellen Umgebung mit dem folgenden Befehl aus.

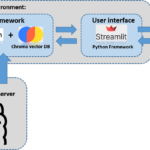

Befehl: streamlit run video_sampling.py --server.port 7777

Jetzt ist die Streamlit App über die URL <IP-Adresse:7777> im Intranet erreichbar und es kann losgehen mit der Video Generierung.

Video erstellen:

Ich habe mir in Automatic1111 mit dem folgenden Prompt ein paar Bilder erzeugt die hoffentlich gut verwendet werden können. Der Prompt den ich verwendet habe ist die folgt.

Generate an image of a surreal alien creature, seamlessly blending with its surroundings. This liquid-like entity should have an otherworldly appearance, with fluidic tendrils and constantly shifting patterns. Imagine a creature that defies our understanding of biological forms, appearing as a mesmerizing combination of liquid and ethereal shapes. Let the colors and textures evoke a sense of mystery and wonder, as if observing a creature from a distant, undiscovered planet. Be creative with the interplay of light and shadow, emphasizing the fluid nature of this extraordinary alien being.

Das von mir in Automatic1111 verwendete Modell hat den Namen: sdxlUnstableDiffusers_v8HeavensWrathVAE.safetensors [b4ab313d84]

Dier erzeugten Bilder sahen dann wie folgt aus.

Die Bilder habe ich hier als ZIP Datei für euch abgelegt: Alien pictures

Jetzt öffnet ihr die URL zu dem Streamlit APP und es sollte die Web-Overfläche von Stable Video Diffusion angezeigt werden.

Jetzt bitte die Check-Box “Load Model” anklicken damit das svd Model geladen wird. Das dauert ein paar Sekunden bis dieses im Speicher der Grafikkarte liegt.

Nach dem das Model geladen ist erhalte ich immer die folgende Fehlermeldung. Allerdings funktioniert die Video Generierung trotzdem.

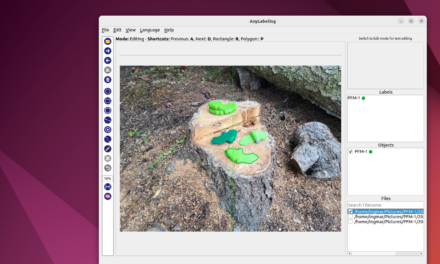

Jetzt das vorbereitete Bild laden. Bei mir ist es das Alien Bild das mir gut gefallen hat.

Jetzt ganz nach unten scrollen und den Knopf Sample drücken. Dann läuft die Video-Generierung los. An den Einstellungen habe ich zunächst nichts verändert. Das folgende Bild zeigt wie viel Speicher von dem svd Modell auf der GPU belegt wird.

Das so erzeugte Video sieht dann wie folgt aus.

Hier ein weiteres kurzes Video.

Zusammenfassug:

Mir hat das Projekt jetzt schon sehr viel Spaß gemacht auch wenn ich häufig Abstürze hatte da der Speicher der Grafikkarte übergelaufen ist. Soll heißen das die Anforderungen an das System schon noch sehr hoch sind. Aber es gibt schon die ersten Modelle die mit ComfyUI in Verbindung lediglich 8GB VideoRAM benötigen. Mehr dazu könnt ihr hier nachlesen CIVITAI. Ich bin sehr gespannt wie es weiter geht und ab wann man richtig lange Szenen als Text-Prompt generieren lassen kann. Prinzipiell ist das jetzt schon möglich wie z. B. mit Automatic1111 und AnimateDiff als Erweiterung.

Hallo, ich habe ihre Anleitung befolgt und bekomme im letzten Schritt leider immer folgende Meldung im Terminal: bash <(wget -qO-…

Hi Dennis, vielen Dank für den Hinweis, ich habe die URLs angepasst so das diese wieder gehen. Ich bin gespannt…

Ich weiss, es ist noch im Aufbau. Aber hier ist ein Broken Link: https://www.ai-box.eu/smurf_training_data_small.zip Freue mich drauf, die ganze Serie…