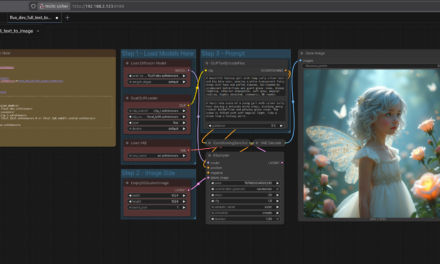

Nachdem ich in meinen vorherigen Beiträgen gezeigt habe, wie ihr Ollama und Open WebUI auf dem Gigabyte AI TOP ATOM installiert, kommt jetzt etwas für alle, die mit KI-generierten Bildern und kurzen KI-generierten Videos experimentieren möchten: ComfyUI – eine leistungsstarke, node-basierte Oberfläche für die Erstellung von KI-Bildern mit Diffusion-Modellen wie Stable Diffusion, SDXL oder Flux.

In diesem Beitrag zeige ich euch, wie ich ComfyUI auf meinem Gigabyte AI TOP ATOM installiert und so konfiguriert habe, dass es im gesamten Netzwerk erreichbar ist. ComfyUI nutzt die volle GPU-Performance der Blackwell-Architektur und ermöglicht es euch, komplexe Workflows für die Bildgenerierung zu erstellen – alles lokal auf eurem eigenen Server. Da das System auf der gleichen Plattform wie die NVIDIA DGX Spark basiert, funktionieren die offiziellen NVIDIA Playbooks hier genauso zuverlässig.

Die spannende Frage für mich ist, ob ich wirklich auch Custome-Workflows installieren kann oder hier an die Grenzen der von NVIDIA verwendeten ARM-Architektur stoße.

Die Grundidee: Node-basierte Bildgenerierung für das eigene lokale Netzwerk

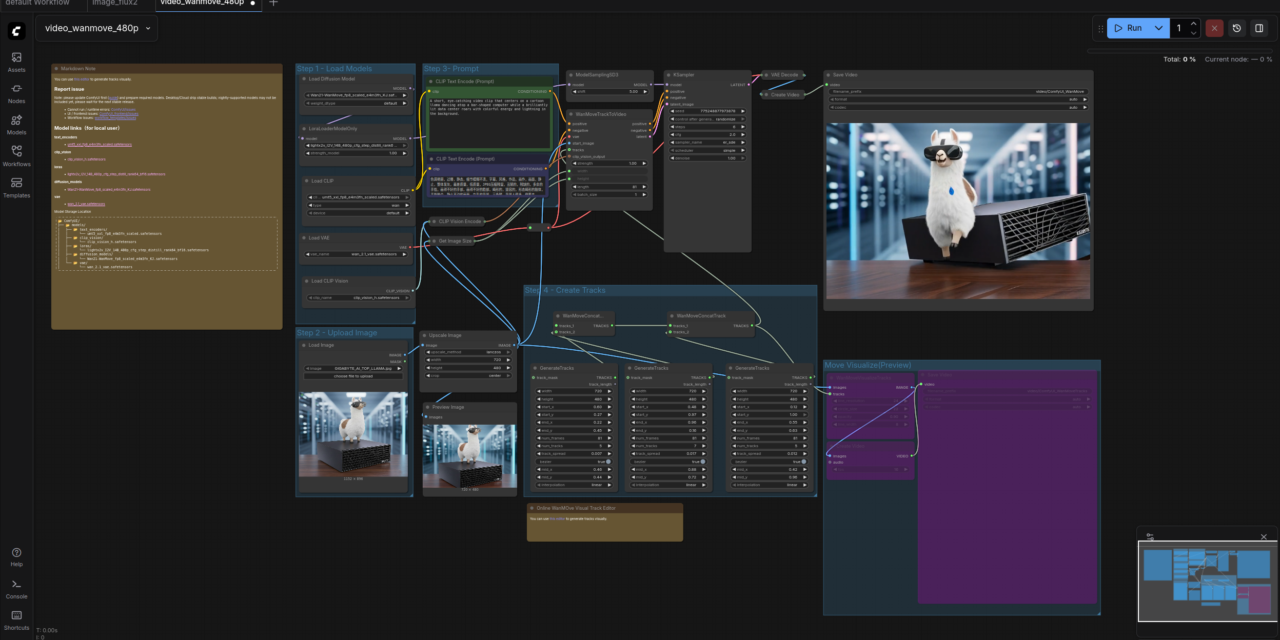

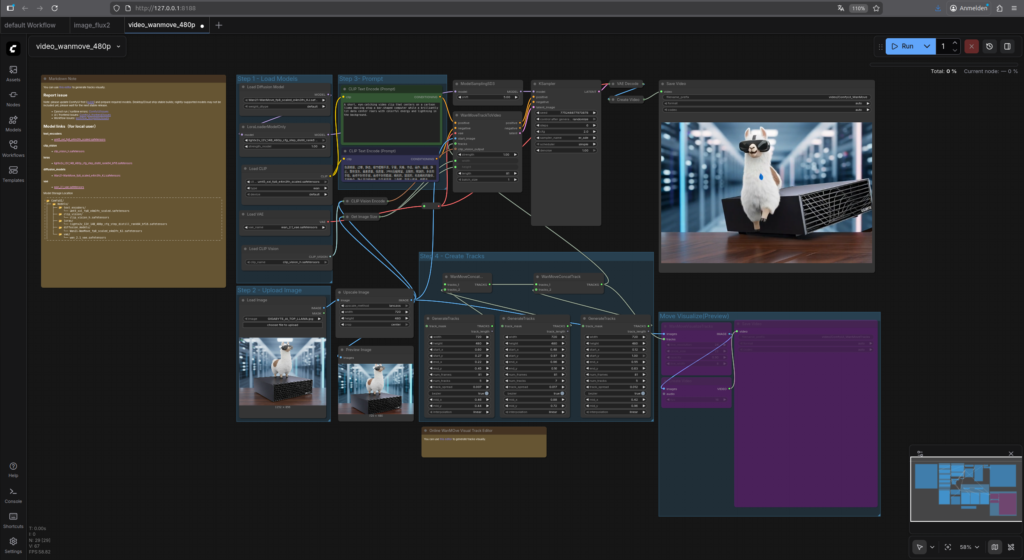

Bevor ich in die technischen Details einsteige, ein wichtiger Punkt: ComfyUI ist eine Web-Anwendung, die direkt auf dem Gigabyte AI TOP ATOM läuft und die GPU-Performance der Blackwell-Architektur nutzt um die Bilder mit Stable-Diffusion Modellen zu erzeugen. Im Gegensatz zu einfachen Bildgenerierungs-Tools verwendet ComfyUI ein node-basiertes System: Jeder Schritt der Bildgenerierung (Modell laden, Text eingeben, Sampling-Parameter setzen) wird als Node dargestellt, die ihr miteinander verbindet, um komplexe Workflows zu erstellen.

Das Besondere daran: Diese Workflows werden als JSON-Dateien gespeichert, sodass ihr sie versionieren, teilen und reproduzieren könnt. Das macht ComfyUI besonders interessant für alle, die ernsthaft mit KI-Bildgenerierung arbeiten möchten – sei es für kreative Projekte, Prototyping oder sogar kommerzielle Anwendungen.

Die ComfyUI Markplatz bzw. Browser für Custome-Workflows der in ComfyUI integriert ist macht ComfyUI um so interessanter da man sehr schnell lernen und ausprobieren kann.

<Bild einfügen vom Browser>

Was ihr dafür braucht:

-

Einen Gigabyte AI TOP ATOM, ASUS Ascent, MSI EdgeXpert (oder NVIDIA DGX Spark) der mit dem Netzwerk verbunden ist

-

Einen angeschlossenen Monitor oder Terminal-Zugriff auf den AI TOP ATOM

-

Einen Computer im gleichen Netzwerk mit einem modernen Browser (optional aber empfehlenswert)

-

Grundkenntnisse in Terminal-Befehlen und Python

-

Mindestens 20 GB freien Speicherplatz für Modelle und Dependencies aber auch gerne mehr.

-

Die IP-Adresse eures AI TOP ATOM im Netzwerk (findet ihr mit

ip addroderhostname -I)

Phase 1: System-Voraussetzungen prüfen

Ich gehe jetzt bei meiner weiteren Anleitung davon aus, dass ihr direkt vor dem AI TOP ATOM sitzt und einen Monitor, Keyboard und Maus angeschlossen habt. Zuerst prüfe ich, ob alle notwendigen System-Voraussetzungen erfüllt sind. Dazu öffne ich ein Terminal auf meinem AI TOP ATOM und führe die folgenden Befehle aus.

Der nachfolgende Befehl zeigt euch, ob Python 3 installiert ist und welche Version läuft.

Befehl: python3 --version

Ihr solltet Python 3.8 oder höher sehen. Als nächstes prüfe ich, ob pip verfügbar ist:

Befehl: pip3 --version

Jetzt prüfe ich, ob das CUDA Toolkit installiert ist:

Befehl: nvcc --version

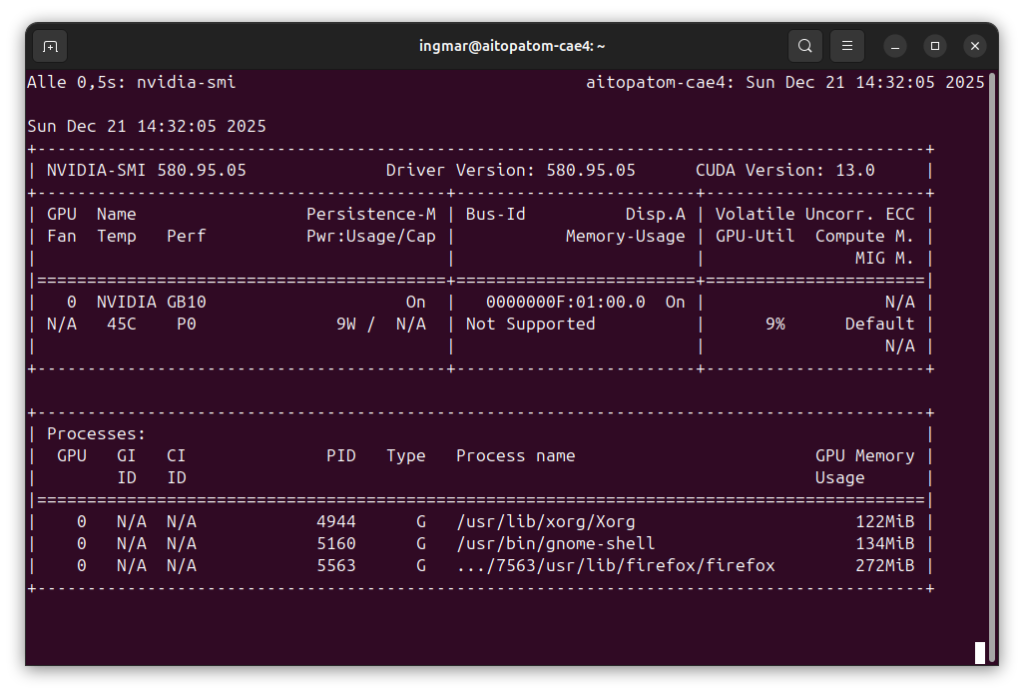

Und schließlich prüfe ich, ob die GPU erkannt wird:

Befehl: nvidia-smi

Ihr solltet jetzt die GPU-Informationen sehen, ähnlich wie in meinem vorherigen Ollama-Blogpost. Falls einer dieser Befehle fehlschlägt, müsst ihr die entsprechenden Komponenten zuerst installieren.

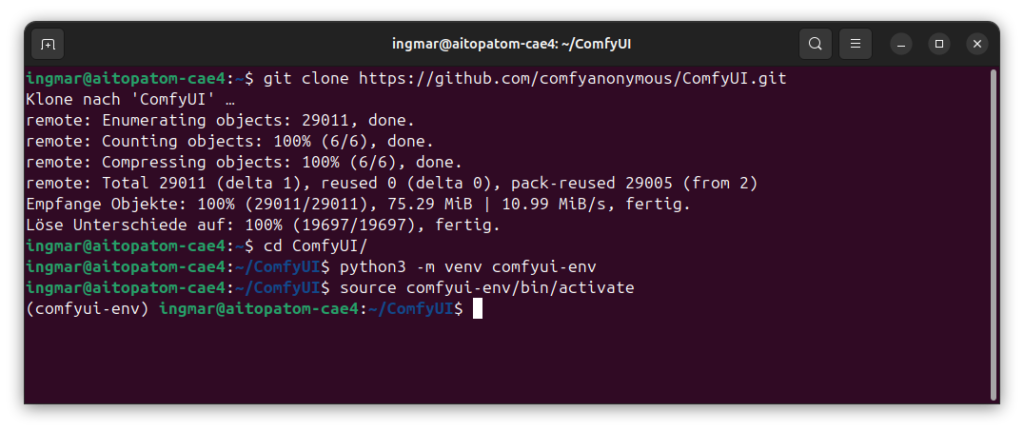

Phase 2: ComfyUI Repository klonen

Jetzt lade ich den ComfyUI Quellcode vom offiziellen GitHub Repository herunter:

Befehl: git clone https://github.com/comfyanonymous/ComfyUI.git

Nach dem Klonen wechsle ich in das ComfyUI Verzeichnis:

Befehl: cd ComfyUI/

Das Repository enthält alle notwendigen Dateien für ComfyUI, einschließlich der Web-Interface-Komponenten und der Model-Handling-Bibliotheken.

Phase 3: Python Virtual Environment erstellen

Um Konflikte mit System-Paketen zu vermeiden, erstelle ich ein isoliertes Python Virtual Environment für ComfyUI. Das ist eine bewährte Praxis und macht es auch einfacher, ComfyUI später wieder zu entfernen, falls nötig.

Falls ihr noch nicht in dem Ordner ComfyUI/ seid wechselt in den Ornder.

Befehl: cd ComfyUI/

Jetzt lasse ich die virtuelle Umgebung erstellen.

Befehl: python3 -m venv comfyui-env

Jetzt aktiviere ich das Virtual Environment:

Befehl: source comfyui-env/bin/activate

Ihr solltet jetzt im Terminal-Prompt (comfyui-env) sehen – das zeigt an, dass das Virtual Environment aktiv ist. Falls nicht, prüft, ob der Befehl korrekt ausgeführt wurde.

Phase 4: PyTorch mit CUDA-Unterstützung installieren

ComfyUI benötigt PyTorch mit CUDA-Unterstützung, um die GPU zu nutzen. Für die Blackwell-Architektur auf dem AI TOP ATOM installiere ich PyTorch mit CUDA 13.0 Unterstützung:

Befehl: pip3 install torch torchvision --index-url https://download.pytorch.org/whl/cu130

Diese Installation kann einige Minuten dauern, da PyTorch ein großes Paket ist. Ich lasse den Download einfach laufen und mache in der Zwischenzeit etwas anderes. Die Installation ist speziell für CUDA 13.0 optimiert, was perfekt mit der Blackwell-Architektur zusammenarbeitet.

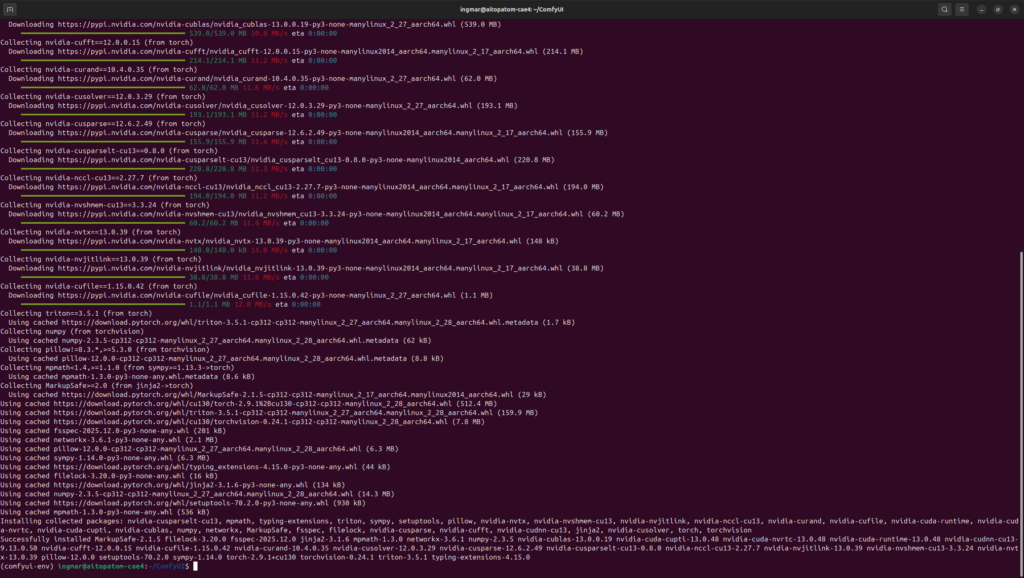

Phase 5: ComfyUI Dependencies installieren

Jetzt installiere ich alle notwendigen Python-Pakete für ComfyUI. Das Repository enthält eine requirements.txt Datei mit allen benötigten Dependencies:

Befehl: pip install -r requirements.txt

Befehl: pip install -r manager_requirements.txt

Diese Installation kann ebenfalls einige Minuten dauern, da viele Pakete heruntergeladen werden müssen. Ich lasse den Prozess einfach laufen und warte, bis alle Pakete installiert sind.

Phase 6: Stable Diffusion Checkpoint herunterladen

Um Bilder generieren zu können, benötigt ComfyUI ein Modell. Ich lade das Stable Diffusion 1.5 Modell herunter, das ein guter Einstiegspunkt ist. Zuerst wechsle ich in das Checkpoints-Verzeichnis:

Befehl: cd models/checkpoints/

Jetzt lade ich das Modell von Hugging Face herunter:

Befehl: wget https://huggingface.co/Comfy-Org/stable-diffusion-v1-5-archive/resolve/main/v1-5-pruned-emaonly-fp16.safetensors

Das Modell ist etwa 2 GB groß und kann je nach Internetgeschwindigkeit einige Minuten dauern. Ihr seht einen Fortschrittsbalken während des Downloads. Nach dem Download wechsle ich zurück ins Hauptverzeichnis:

Befehl: cd ../../

Wichtiger Hinweis: Stellt sicher, dass genug Speicherplatz auf eurem AI TOP ATOM verfügbar ist. Falls der Download mit einem Speicherfehler abbricht, könnt ihr auch später weitere Modelle hinzufügen oder kleinere Modelle verwenden.

Hier geht es zum 2. Teil der Installations- und Konfigurationsanleitung.

Ein toller Guide der leicht zugänglich und verständlich ist. Perfekt für ein kleines Side-Project geeignet. Aktuell half mir noch mein…

Thank you for this great tutorial, could you share n8n workflow and comfyui workflow please?

Hallo Anton, die Meldung besagt das in meinem Beisiel Methoden verwendet werden die veraltet (deprecated) sind. Also müsstest Du die…

Danke für das Tool! Ich habe erst kürzlich angefangen mich mit der Thematik zu beschäftigen und bin für meine Erwartungen…

Hallo, ich habe ihre Anleitung befolgt und bekomme im letzten Schritt leider immer folgende Meldung im Terminal: bash <(wget -qO-…