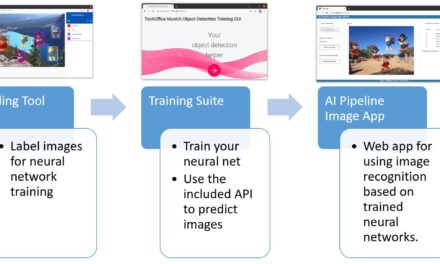

Nachdem ich in meinen vorherigen Beiträgen gezeigt habe, wie ihr Ollama, Open WebUI, LLaMA Factory, vLLM und ComfyUI auf dem Gigabyte AI TOP ATOM installiert, kommt jetzt etwas für alle, die ihre eigenen Stable Diffusion AI-Modelle trainieren möchten: AI Toolkit von Ostris – eine umfassende Lösung für das Training von Stable Diffusion Modellen mit einer benutzerfreundlichen Web-Oberfläche.

In diesem Beitrag zeige ich euch, wie ich das AI Toolkit auf meinem Gigabyte AI TOP ATOM installiert und konfiguriert habe, um eigene Modelle zu trainieren und anzupassen. Das AI Toolkit nutzt die volle GPU-Performance der Blackwell-Architektur und bietet eine intuitive Web-UI für die Konfiguration und Überwachung von Trainingsjobs. Da das System auf der gleichen Plattform wie die NVIDIA DGX Spark basiert, funktionieren die offiziellen NVIDIA Playbooks hier genauso zuverlässig. Für meine Erfahrungsberichte hier auf meinem Blog habe ich den Gigabyte AI TOP ATOM von der Firma MIFCOM einen Spezialisten für Hochleistungs- und Gaming-Rechner aus München ausgeliehen bekommen.

Die Grundidee: Eigene AI-Modelle trainieren mit einer benutzerfreundlichen Oberfläche

Bevor ich in die technischen Details einsteige, ein wichtiger Punkt: AI Toolkit ist eine umfassende Lösung für das Training von Large Language Models und anderen KI-Modellen. Im Gegensatz zu komplexen manuellen Setups bietet das AI Toolkit eine intuitive Web-Oberfläche, über die ihr Trainingsjobs konfigurieren, starten und überwachen könnt – ohne komplexe Kommandozeilen-Befehle oder YAML-Dateien manuell bearbeiten zu müssen.

Das Besondere daran: Das AI Toolkit läuft direkt auf eurem AI TOP ATOM und nutzt die 128 GB Speicher und die volle GPU-Performance der Blackwell-Architektur. Die Installation erfolgt über eine virtuelle Conda-Umgebung mit Python 3.11, was eine saubere Isolation von der System-Python-Installation ermöglicht. Die Web-UI läuft auf Port 8675 und ist von jedem Computer im Netzwerk erreichbar, sodass ihr Trainingsjobs auch von anderen Rechnern aus starten und überwachen könnt.

Was ihr dafür braucht:

-

Einen Gigabyte AI TOP ATOM, ASUS Ascent, MSI EdgeXpert (oder NVIDIA DGX Spark) der mit dem Netzwerk verbunden ist

-

Einen angeschlossenen Monitor oder Terminal-Zugriff auf den AI TOP ATOM

-

Grundkenntnisse in Terminal-Befehlen, Python und Conda

-

Mindestens 20 GB freien Speicherplatz für Conda, PyTorch und Dependencies und vor allem die Basis Modelle die ihr erweitern möchtet

-

Eine Internetverbindung zum Download von Miniconda, PyTorch und Node.js

-

Die dgx_requirements.txt Datei des AI Toolkits (sollte im AI Toolkit Repository enthalten sein)

-

Einen Computer im gleichen Netzwerk mit einem modernen Browser für die Web-UI

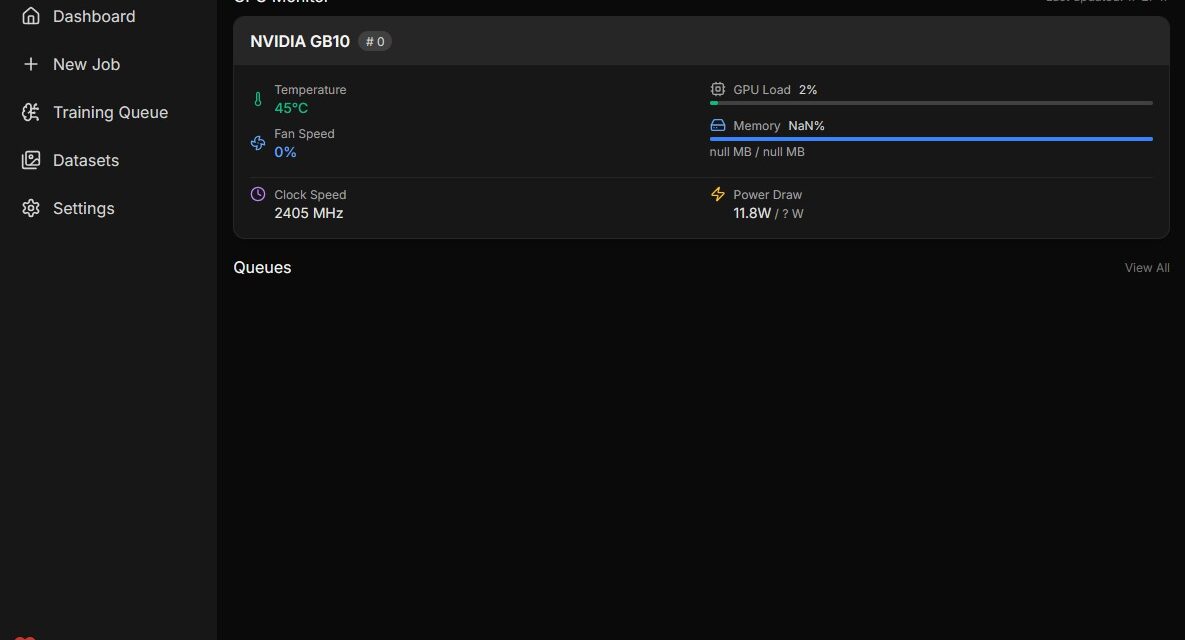

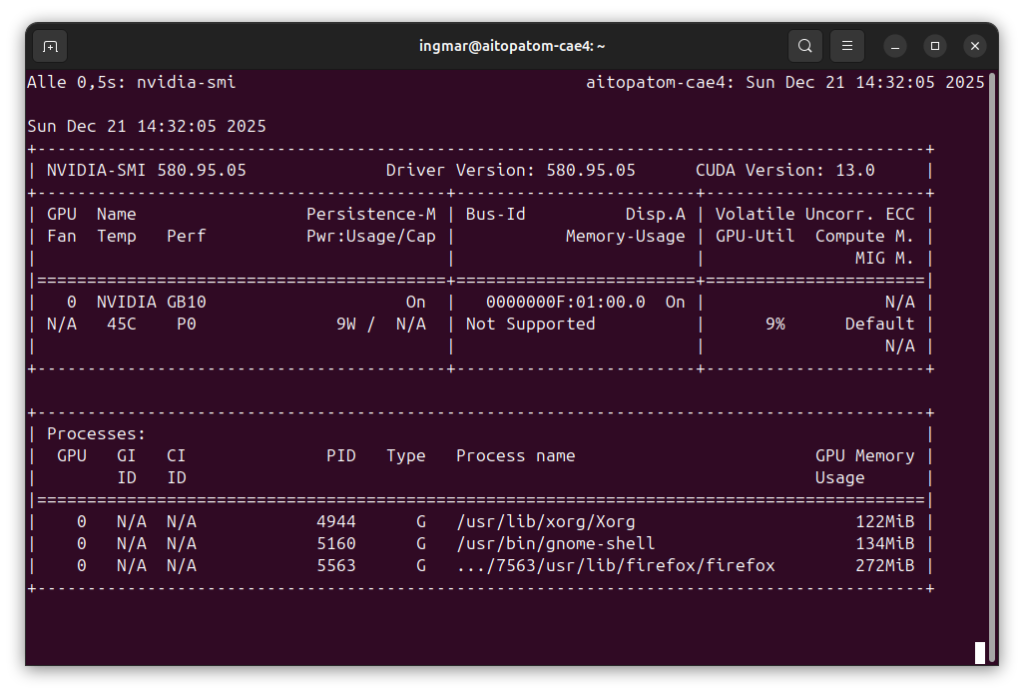

Phase 1: System-Voraussetzungen prüfen

Ich gehe jetzt bei meiner weiteren Anleitung davon aus, dass ihr direkt vor dem AI TOP ATOM oder der NVIDIA DGX Spark sitzt und einen Monitor, Keyboard und Maus angeschlossen habt. Zuerst prüfe ich, ob alle notwendigen System-Voraussetzungen erfüllt sind. Dazu öffne ich ein Terminal auf meinem AI TOP ATOM und führe die folgenden Befehle aus.

Der nachfolgende Befehl zeigt euch, ob das CUDA Toolkit installiert ist:

Befehl: nvidia-smi

Ihr solltet jetzt die GPU-Informationen sehen. Falls nicht, müsst ihr zuerst die NVIDIA-Treiber installieren. Prüft auch, ob Python bereits installiert ist:

Befehl: python3 --version

Das AI Toolkit benötigt Python 3.11, aber wir installieren das über Miniconda, sodass die System-Python-Version nicht kritisch ist. Prüft auch, ob wget verfügbar ist:

Befehl: wget --version

Falls einer dieser Befehle fehlschlägt, müsst ihr die entsprechenden Komponenten zuerst installieren.

Als nächstes habe ich das AI-Toolkit von GitHub herunter geladen und folge dieser Schritt für Schritt Anleitung DGX OS installation instructions. Dazu hab eich den folgenden Befehl im Home-Verzeichnis meines User ausgeführt.

Befehl: git clone https://github.com/ostris/ai-toolkit.git

Befehl: cd ai-toolkit

Phase 2: Miniconda installieren

Das AI Toolkit benötigt Python 3.11, und die einfachste Methode, dies ohne die System-Python-Installation zu beeinflussen, ist die Verwendung von Miniconda. Miniconda ermöglicht es, isolierte Python-Umgebungen mit spezifischen Python-Versionen zu erstellen. Ich lade zuerst die neueste Version von Miniconda für Linux ARM64 herunter:

Befehl: wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-aarch64.sh

Nach dem Download mache ich das Installationsskript ausführbar:

Befehl: chmod u+x Miniconda3-latest-Linux-aarch64.sh

Jetzt starte ich die Installation:

Befehl: ./Miniconda3-latest-Linux-aarch64.sh

Während der Installation werdet ihr nach dem Installationspfad gefragt. Der Standardpfad ist ~/miniconda3, was für die meisten Fälle ausreicht. Ich akzeptiere die Standardeinstellungen und lasse Miniconda auch die PATH-Variable in der ~/.bashrc Datei setzen. Dazu habe ich einfach mehrfach mit ja bzw. yes die Nachfragen bestätigt.

Wichtiger Hinweis: Nach der Installation müsst ihr eure Bash-Session neu starten oder die ~/.bashrc Datei neu laden, damit Conda verfügbar ist:

Befehl: source ~/.bashrc

Oder einfach ein neues Terminal-Fenster öffnen. Wenn Miniconda erfolgreich installiert wurde, seht ihr (base) am Anfang eures Terminal-Prompts, was bedeutet, dass die Basis-Conda-Umgebung aktiviert ist.

Falls ihr nicht möchtet, dass die Basis-Umgebung automatisch aktiviert wird, könnt ihr das mit folgendem Befehl deaktivieren:

Befehl: conda config --set auto_activate_base false

Ich persönlich lasse die automatische Aktivierung nicht aktiviert, da ich eher seltern conda virtuelle Umgebungen nutze stattdessen aber Python virtuelle Umgebungen.

Phase 3: Conda-Umgebung für AI Toolkit erstellen

Jetzt erstelle ich eine neue Conda-Umgebung speziell für das AI Toolkit mit Python 3.11:

Befehl: conda create --name ai-toolkit python=3.11

Conda wird euch nach einer Vielzahl an Bestätigung fragen die ihr mit ja / yes beantworten müsst. Anschließend wird die conda Umgebung erstellt. Das kann einige Minuten dauern. Nach der Erstellung aktiviere ich die Umgebung:

Befehl: conda activate ai-toolkit

Ihr solltet jetzt sehen, dass sich euer Prompt im Terminal Fenster von (base) auf (ai-toolkit) ändert also jetzt (ai-toolkit) am Anfang steht. Das bedeutet, dass die virtuelle (ai-toolkit) Conda Umgebung aktiviert ist und alle folgenden Befehle in dieser Umgebung ausgeführt werden um das AI-Toolkit zu installieren.

Wichtiger Hinweis: Die Conda-Umgebung (ai-toolkit) muss bei jedem neuen Terminal-Fenster aktiviert werden. Falls ihr die Umgebung vergesst zu aktivieren, werden die folgenden Installationen nicht funktionieren oder auch später das starten des AI-Toolkit.

Phase 4: PyTorch installieren

Das AI Toolkit benötigt PyTorch mit CUDA-Unterstützung. Ich installiere die spezifische Version, die für die Blackwell-Architektur optimiert ist in die virtuelle (ai-toolkit) Umgebung:

Befehl: pip3 install torch==2.9.1 torchvision==0.24.1 torchaudio==2.9.1 --index-url https://download.pytorch.org/whl/cu130

Diese Installation kann einige Minuten dauern, da PyTorch und die zugehörigen Pakete relativ groß sind. Der Parameter --index-url stellt sicher, dass wir die CUDA 13.0-kompatiblen Versionen herunterladen, die für die Blackwell-GPU optimiert sind.

Nach der Installation prüfe ich, ob PyTorch korrekt installiert wurde und CUDA-Unterstützung verfügbar ist:

Befehl: python -c "import torch; print(f'PyTorch: {torch.__version__}, CUDA available: {torch.cuda.is_available()}')"

Ihr solltet eine Ausgabe sehen, die etwa so aussieht:

PyTorch: 2.9.1+cu130, CUDA available: TrueFalls CUDA available: False angezeigt wird, gibt es ein Problem mit der CUDA-Installation oder den Treibern. Prüft dann mit nvidia-smi, ob die GPU erkannt wird.

Phase 5: Weitere Requirements installieren

Jetzt installiere ich die restlichen Abhängigkeiten des AI Toolkits. Diese waren zum Zeitpunkt meiner Installation in der Datei namens dgx_requirements.txt enthalten , die im AI Toolkit Repository zu finden ist.

Hinweis: Falls ihr das Repository noch nicht geklont habt, müsst ihr das zuerst tun wie weiter oben im Abschnitt Phase 1 und dort am Ende es beschrieben ist:

Befehl: pip3 install -r dgx_requirements.txt

Diese Installation kann ebenfalls einige Minuten dauern, je nachdem, wie viele Pakete in der Requirements-Datei aufgelistet sind. Pip installiert automatisch alle Abhängigkeiten und deren Abhängigkeiten.

Wichtiger Hinweis: Stellt sicher, dass die Conda-Umgebung (ai-toolkit) aktiviert ist, bevor ihr diesen Befehl ausführt. Falls nicht, werden die Pakete in der falschen Umgebung installiert.

Phase 6: Node.js für ARM64 installieren

Die Web-UI des AI Toolkits benötigt Node.js. Da der AI TOP ATOM eine ARM64-Architektur (NVIDIA Grace CPU) verwendet, benötigen wir eine ARM64-Version von Node.js. Die Standard-Node.js-Installation über apt funktioniert hier nicht zuverlässig, daher installieren wir Node.js manuell.

Zuerst lade ich eine Linux ARM64 Build von Node.js von der offiziellen Node.js-Website herunter. Ich verwende hier Version 24.11.1 als Beispiel, aber ihr könnt auch eine neuere Version verwenden:

Befehl: wget https://nodejs.org/dist/v24.11.1/node-v24.11.1-linux-arm64.tar.xz

Nach dem Download extrahiere ich das Archiv:

Befehl: tar -xf node-v24.11.1-linux-arm64.tar.xz

Jetzt verschiebe ich das extrahierte Verzeichnis nach /opt, damit es systemweit verfügbar ist:

Befehl: sudo mv node-v24.11.1-linux-arm64 /opt/

Jetzt füge ich den Node.js bin-Verzeichnis zum PATH hinzu. Dazu bearbeite ich die ~/.bashrc Datei:

Befehl: nano ~/.bashrc

Am Ende der Datei füge ich folgende Zeile hinzu:

export PATH="/opt/node-v24.11.1-linux-arm64/bin:$PATH"Speichert die Datei (in nano: Ctrl+O, dann Enter, dann Ctrl+X) und lade die ~/.bashrc neu:

Befehl: source ~/.bashrc

Jetzt prüfe ich, ob Node.js korrekt installiert wurde:

Befehl: node --version

Ihr solltet eine Versionsnummer sehen, z.B. v18.19.1. Falls der Befehl nicht gefunden wird, prüft, ob der PATH korrekt gesetzt ist.

Phase 7: npm installieren

Die Node.js-Installation enthält normalerweise bereits npm, aber für die DGX Spark Plattform und den AI TOP ATOM kann es sein, dass npm zusätzlich installiert werden muss. npm wird benötigt, um die Node.js-Abhängigkeiten der Web-UI zu installieren und die UI zu kompilieren.

Zuerst prüfe ich, ob npm bereits verfügbar ist:

Befehl: npm --version

Falls npm nicht gefunden wird oder eine Fehlermeldung erscheint, installiere ich npm über apt. Das war in meinem Fall notwendig:

Befehl: sudo apt install npm

Diese Installation kann einige Minuten dauern. Nach der Installation prüfe ich erneut:

Befehl: npm --version

Ihr solltet jetzt eine Versionsnummer sehen, z.B. 9.2.0 oder ähnlich.

Wichtiger Hinweis: Dieser Schritt wurde in der ursprünglichen Anleitung zum AI-Toolkit nicht aufgeführt, ist aber notwendig, damit die Web-UI kompiliert werden kann. Ohne npm wird der jetzt folgende Build-Prozess fehlschlagen.

Hier geht es zum Teil 2/2: AI Toolkit auf Gigabyte AI TOP ATOM installieren – Schritt-für-Schritt Anleitung – Teil 2-2

Ein toller Guide der leicht zugänglich und verständlich ist. Perfekt für ein kleines Side-Project geeignet. Aktuell half mir noch mein…

Thank you for this great tutorial, could you share n8n workflow and comfyui workflow please?

Hallo Anton, die Meldung besagt das in meinem Beisiel Methoden verwendet werden die veraltet (deprecated) sind. Also müsstest Du die…

Danke für das Tool! Ich habe erst kürzlich angefangen mich mit der Thematik zu beschäftigen und bin für meine Erwartungen…

Hallo, ich habe ihre Anleitung befolgt und bekomme im letzten Schritt leider immer folgende Meldung im Terminal: bash <(wget -qO-…