Nachdem ich im letzten Beitrag gezeigt habe, wie ihr Ollama auf dem Gigabyte AI TOP ATOM installiert und für Netzwerk-Zugriff konfiguriert, kommt jetzt der nächste logische Schritt: Eine benutzerfreundliche Chat-Oberfläche, die jeder im Netzwerk nutzen kann. Open WebUI ist genau das – eine selbst gehostete, erweiterbare KI-Oberfläche, die vollständig offline funktioniert und direkt mit Ollama zusammenarbeitet.

In diesem Beitrag zeige ich euch, wie ich Open WebUI auf meinem Gigabyte AI TOP ATOM installiert und so konfiguriert habe, dass es im gesamten Netzwerk erreichbar ist. Zusammen mit dem bereits laufenden Ollama-Server habt ihr dann eine komplette Chat-Lösung – ähnlich wie ChatGPT, aber lokal gehostet und mit eurer eigenen GPU-Power. Da das System auf der gleichen Plattform wie die NVIDIA DGX Spark basiert, funktionieren die offiziellen NVIDIA Playbooks hier genauso zuverlässig. Für meine Berichte hier auf meinem Blog habe ich den Gigabyte AI TOP ATOM von der in München ansässigen Firma MIFCOM bereitgestellt bekommen.

Die Grundidee: ChatGPT-ähnliche Oberfläche für das eigene Netzwerk

Bevor ich in die technischen Details einsteige, ein wichtiger Punkt: Open WebUI ist eine Web-Anwendung, die über Docker läuft und ein integriertes Ollama-Server enthält. Das bedeutet, ihr könnt entweder euren bereits installierten Ollama-Server nutzen oder das integrierte Ollama verwenden. Ich nutze hier das integrierte Ollama, da es einfacher zu verwalten ist und alles in einem Container läuft.

Die Installation erfolgt über Docker, was bedeutet, dass alles sauber isoliert ist und sich einfach wieder entfernen lässt. Open WebUI läuft dann auf Port 8080 (oder einem anderen Port eurer Wahl) und ist von jedem Computer im Netzwerk über den Browser erreichbar. Keine komplexe Konfiguration, keine API-Aufrufe über cURL – einfach im Browser öffnen und chatten.

Was ihr dafür braucht:

-

Einen Gigabyte AI TOP ATOM (oder NVIDIA DGX Spark) der mit dem Netzwerk verbunden ist

-

Docker installiert und funktionsfähig (ist bei DGX OS standardmäßig vorhanden)

-

Terminal-Zugriff auf den AI TOP ATOM (über SSH oder direkt)

-

Einen Computer im gleichen Netzwerk mit einem modernen Browser

-

Grundkenntnisse in Docker und Terminal-Befehlen

-

Genug Speicherplatz für das Container-Image und Modell-Downloads (empfohlen: mindestens 50 GB frei)

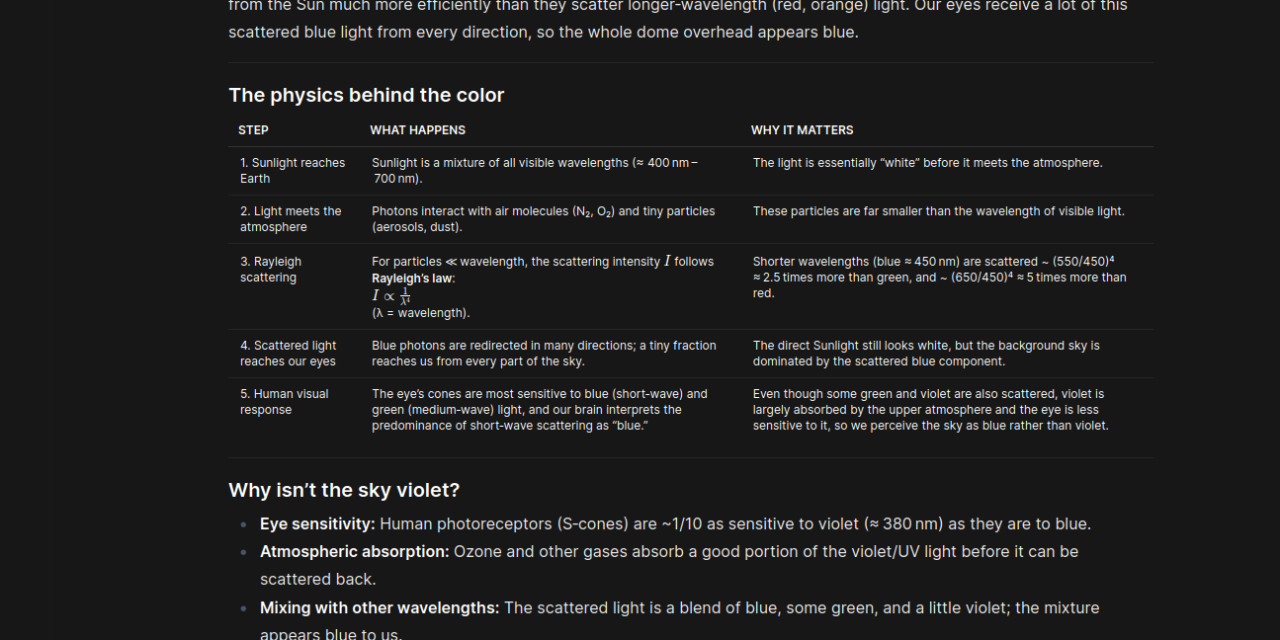

Phase 1: Docker-Berechtigungen konfigurieren

Zuerst stelle ich sicher, dass ich Docker-Befehle ohne sudo ausführen kann. Das macht die Arbeit deutlich einfacher. Ich öffne ein Terminal auf meinem AI TOP ATOM und teste den Docker-Zugriff:

Befehl: sudo docker ps

Falls ihr eine Fehlermeldung wie „permission denied while trying to connect to the Docker daemon socket“ bekommt wie im nachfolgenden Bild bei mir zu sehen ist, müsst ihr euren Benutzer zur Docker-Gruppe hinzufügen:

Befehl: sudo usermod -aG docker $USER

Befehl:newgrp docker

Der Befehl newgrp docker aktiviert die neue Gruppenmitgliedschaft sofort, ohne dass ihr euch neu einloggen müsst. Ich teste nochmal mit docker ps – jetzt sollte es ohne Fehler funktionieren.

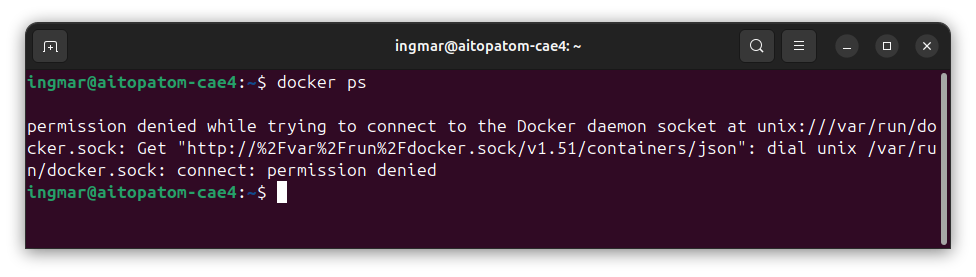

Phase 2: Open WebUI Container-Image herunterladen

Jetzt lade ich das Open WebUI Container-Image herunter. Ich nutze die Standard Version main ohne integriertem Ollama, da Ollama bereits bei mir installiert ist.

Befehl: docker pull ghcr.io/open-webui/open-webui:main

Je nach Internetgeschwindigkeit kann der Download ein paar Minuten dauern – das Image ist etwa 2-3 GB groß. Ich lasse den Download einfach laufen und mache in der Zwischenzeit etwas anderes.

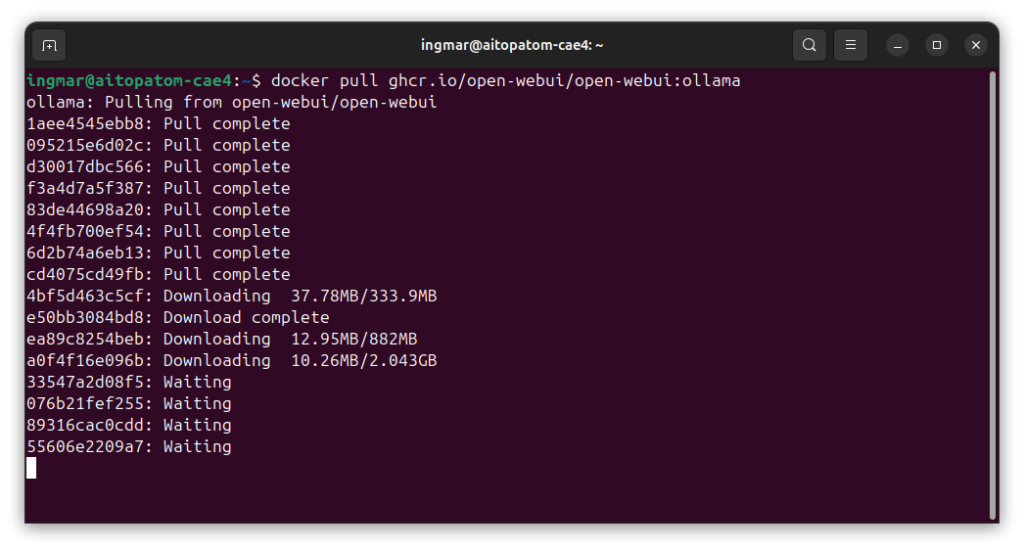

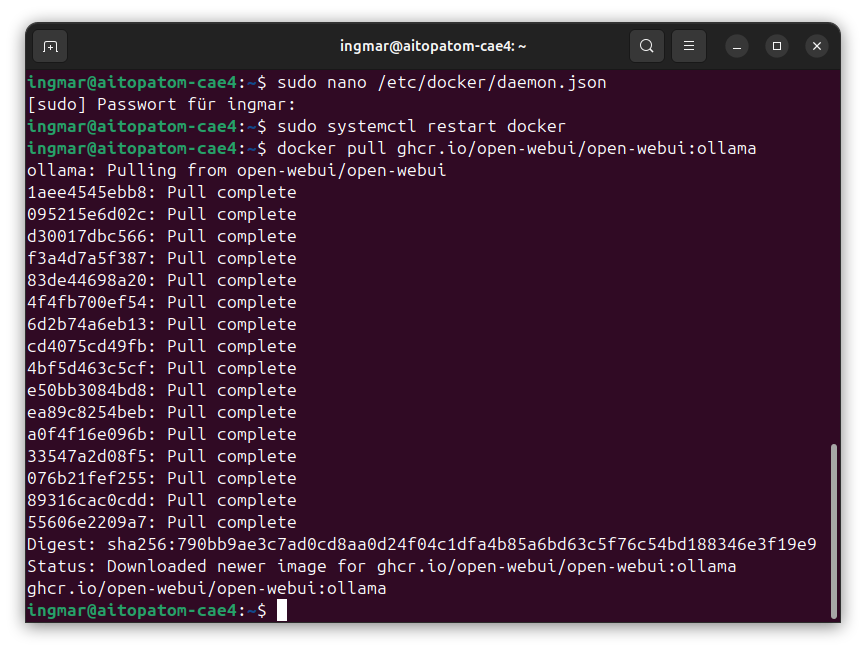

Hinweis: Ich hatte ganz viele Donwload Abbrücke mit der folgenden Meldung:

Mein Lösungsversuch der auch erfolgreich war sah so aus, dass ich die maximale Anzahl an parallel laufenden Downloads auf 1 Donwload beschränkt habe. Dazu den folgenden Befehl ausführen:

Befehl: sudo nano /etc/docker/daemon.json

Mit diesem Befehl legt ihr eine neue daemon.json Datei an mit dem folgenden Inhalt:

{

"max-concurrent-downloads":1

}

Damit die Anpassung wirksam wird jetzt noch den Docker Service mit dem nachfolgenden Befehl neustarten:

Befehl: sudo systemctl restart docker

Anschließend habe ich den Fehler nicht mehr bekommen und konnte Open WebUI für Ollama erfolgreich herunter laden.

Wenn der Download abgeschlossen ist, seht ihr eine Meldung wie „Status: Downloaded newer image for ghcr.io/open-webui/open-webui:ollama“.

Phase 3: Open WebUI Container starten

Jetzt starte ich den Open WebUI Container. Wichtig ist hier, dass ich den Port so konfiguriere, dass er im Netzwerk erreichbar ist. Ich nutze Port 3000, aber ihr könnt auch einen anderen Port wählen, falls dieser bereits belegt ist:

Befehl: docker run -d -p 0.0.0.0:3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

Lass mich die Parameter erklären:

-

-d: Container läuft im Hintergrund (detached mode) -

-p 0.0.0.0:3000:8080: Port-Mapping – Port 8080 des Containers wird auf Port 8080 des Hosts gemappt und ist mit 0.0.0.0 über das Intranet von allen Rechnern aus erreichbar. -

--add-hos: Dieser Parameter fügt der internen/etc/hosts-Datei des Containers einen Eintrag hinzu. Er sagt dem Container: „Wenn du die Adressehost.docker.internalaufrufst, leite die Anfrage an die IP-Adresse des Host-Gateways (deine DGX) weiter.“ -

-v open-webui:/app/backend/data: Persistentes Volume für Open WebUI-Daten (Chats, Einstellungen) -

-v open-webui-ollama:/root/.ollama: Persistentes Volume für heruntergeladene Modell --name open-webui: Name des Containers für einfache Verwaltung

Nach dem Start sollte der Container laufen. Ich prüfe das mit:

Befehl:docker ps

Ihr solltet den Container „open-webui“ in der Liste sehen. Falls nicht, prüft die Logs mit docker logs open-webui, um zu sehen, was schiefgelaufen ist.

Prüfe die Logs des Containers mit dem folgenden Befehl, um zu sehen, ob das Backend wirklich gestartet ist:

Befehl: docker logs -f open-webui

Phase 4: Netzwerk-Zugriff konfigurieren (optional)

Standardmäßig sollte Open WebUI jetzt bereits im Netzwerk erreichbar sein, da wir Port 8080 exponiert haben. Ich hatte keine Probleme aber dennoch hier ein paar Tips was ihr machen könnt. Ich prüfe zuerst die IP-Adresse meines AI TOP ATOM:

Befehl:hostname -I

Ich notiere mir die IP-Adresse (z.B. 192.168.1.100). Falls eine Firewall aktiv ist, muss ich Port 8080 freigeben:

Befehl:sudo ufw allow 8080

Jetzt öffne ich auf einem anderen Computer im Netzwerk einen Browser und navigiere zu http://192.168.1.100:8080 (wieder mit eurer IP-Adresse). Die Open WebUI Oberfläche sollte sich öffnen.

Wichtiger Hinweis: Beim ersten Start kann es ein paar Minuten dauern, bis die Seite lädt. Open WebUI initialisiert sich und lädt möglicherweise erste Modelle. Einfach warten und die Seite gegebenenfalls neu laden.

Phase 5: Administrator-Account erstellen

Wenn die Open WebUI Oberfläche geladen ist, seht ihr eine Willkommensseite. Ich klicke auf den Button „Get Started“ am unteren Rand des Bildschirms.

Jetzt muss ich einen Administrator-Account erstellen. Das ist ein lokales Konto, das nur für diese Open WebUI Installation gilt – keine Verbindung zu externen Diensten. Ich fülle das Formular aus:

-

Benutzername (z.B. „admin“ oder euer Name)

-

E-Mail-Adresse (optional, aber empfohlen)

-

Passwort (wählt ein sicheres Passwort, da der Server im Netzwerk erreichbar ist)

Nach dem Klick auf „Register“ oder „Create Account“ sollte ich direkt zur Hauptoberfläche weitergeleitet werden. Falls ihr Fehlermeldungen seht, prüft die Container-Logs mit docker logs open-webui.

Verbindung zu Ollama einrichten

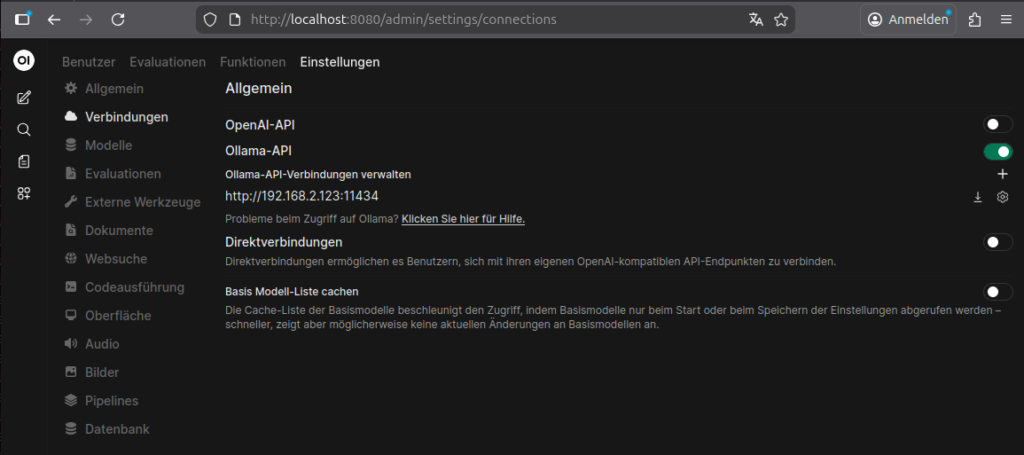

Jetzt müsst ihr unter den Einstellungen von Open WebUI noch die Verbindung zu eurer Ollama-Installation herstellen. Das macht ihr wie folgt.

Dazu also auf Einstellungen -> Administration klicken und den Eintrag Verbindungen öffnen. Ich habe dann die IP-Adresse meines AI TOP ATOM hinterlegt gefolgt vom Port wie im folgenden Bild zu sehen ist. Nach einem Neustart des Rechners hat alles einwandfrei funktioniert.

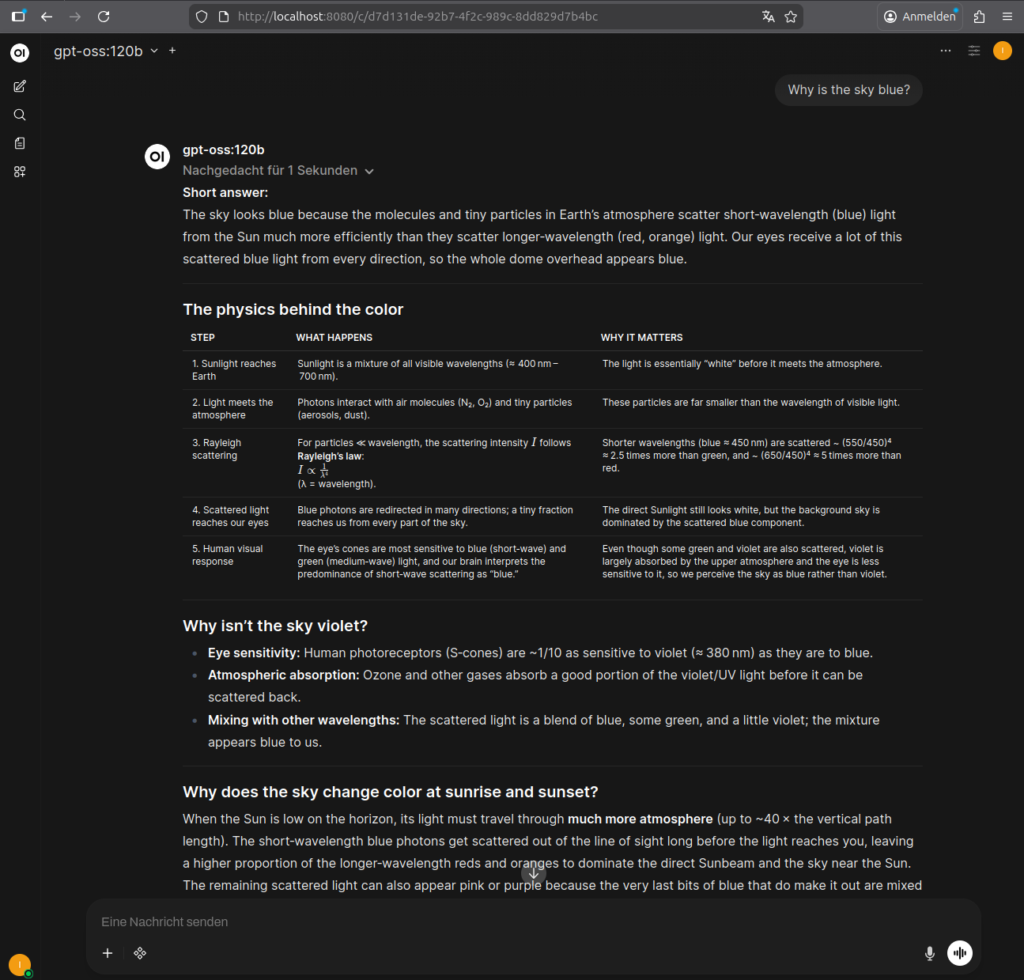

Phase 6: Erste Chat-Nachricht testen

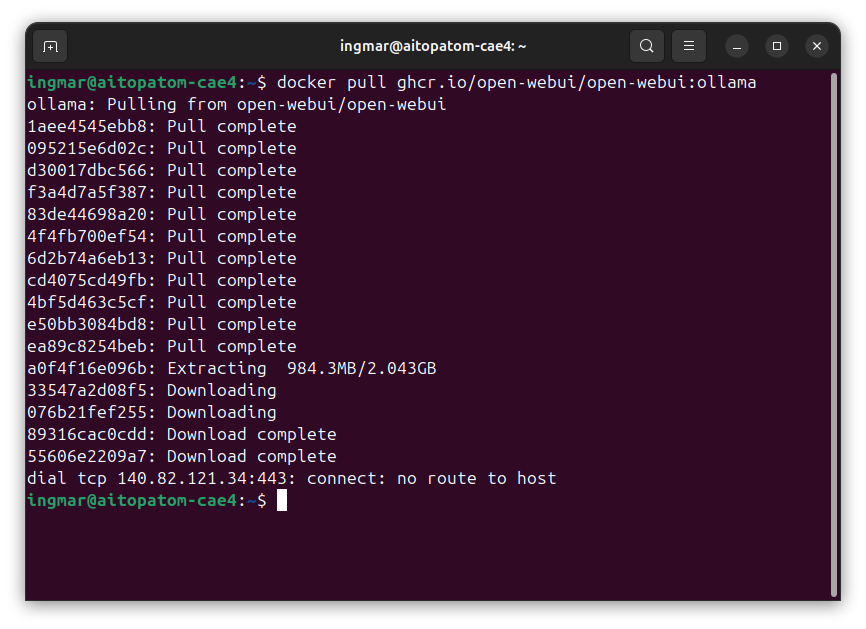

Jetzt kann ich endlich chatten! Ich gebe in das Chat-Eingabefeld am unteren Rand der Oberfläche ein: „Warum ist der Himmel blau?“ und drücke Enter. Oben links sollte bereits ein Sprachen-Modell ausgewählt sein das ihr bereits mit Ollama herunter geladen habt.

Das Modell sollte jetzt eine Antwort generieren. Ihr seht die Antwort in Echtzeit, während sie geschrieben wird – genau wie bei ChatGPT. Die GPU des AI TOP ATOM arbeitet im Hintergrund und berechnet die Antwort. Je nach Modellgröße und Komplexität der Anfrage kann das ein paar Sekunden dauern.

Wenn alles funktioniert, habt ihr jetzt eine vollständige Chat-Lösung, die von jedem Computer im Netzwerk genutzt werden kann. Einfach die IP-Adresse des AI TOP ATOM im Browser öffnen und loslegen!

Weitere Modelle ausprobieren

Das Schöne an Open WebUI ist die große Auswahl an verfügbaren Modellen. Über das Modell-Dropdown könnt ihr weitere Modelle aus der Ollama Library herunterladen. Ich habe zum Beispiel auch folgende Modelle getestet:

-

llama3.1:8b – Sehr vielseitig und schnell

-

codellama:13b – Brilliert bei Code-Generierung

-

qwen2.5:32b – Optimiert für Blackwell-GPUs, sehr leistungsstark

-

phi3.5:3.8b – Kompakt und schnell, perfekt für einfachere Aufgaben

Jedes Modell hat seine Stärken. Probiert einfach aus, welches am besten zu euren Anforderungen passt. Die Modelle werden im persistenten Volume gespeichert, sodass ihr sie nicht bei jedem Container-Neustart erneut herunterladen müsst.

Container-Verwaltung: Starten, Stoppen, Neustarten

Falls ihr den Container stoppen möchtet (z.B. um Ressourcen freizugeben), nutzt:

Befehl:docker stop open-webui

Um ihn wieder zu starten:

Befehl:docker start open-webui

Um den Container neu zu starten:

Befehl:docker restart open-webui

Um den Status zu prüfen:

Befehl:docker ps -a | grep open-webui

Die persistenten Volumes bleiben erhalten, auch wenn der Container gestoppt wird. Alle Chats, Einstellungen und heruntergeladenen Modelle bleiben erhalten.

Troubleshooting: Häufige Probleme und Lösungen

In meiner Zeit mit Open WebUI auf dem AI TOP ATOM bin ich auf einige typische Probleme gestoßen. Hier sind die häufigsten und wie ich sie gelöst habe:

-

„Permission denied“ bei Docker-Befehlen: Der Benutzer ist nicht in der Docker-Gruppe. Führt

sudo usermod -aG docker $USERaus und startet die Terminal-Session neu. -

Seite lädt nicht im Browser: Prüft, ob der Container läuft mit

docker ps. Beim ersten Start kann es einige Minuten dauern. Prüft auch die Logs mitdocker logs open-webui. -

Modell-Download schlägt fehl: Prüft die Internetverbindung und den verfügbaren Speicherplatz. Mit

df -hkönnt ihr den Speicherplatz prüfen. - Port 8080 bereits belegt: Nutzt einen anderen Port, z.B.

-p 8081:8080im docker run Befehl. Dann ist Open WebUI unter Port 8081 erreichbar. -

Langsame Inferenz: Das Modell könnte zu groß für den verfügbaren GPU-Speicher sein. Probiert ein kleineres Modell oder prüft mit

nvidia-smidie GPU-Auslastung. -

Zugriff aus dem Netzwerk funktioniert nicht: Prüft die Firewall-Einstellungen und stellt sicher, dass der Port freigegeben ist. Prüft auch, ob beide Computer im gleichen Netzwerk sind.

Container aktualisieren

Falls Open WebUI eine Update-Benachrichtigung anzeigt oder ihr die neueste Version nutzen möchtet, aktualisiert ihr den Container wie folgt:

Befehl:

docker stop open-webui

docker rm open-webui

docker pull ghcr.io/open-webui/open-webui:ollama

docker run -d -p 0.0.0.0:8080:8080 -v open-webui:/app/backend/data -v open-webui-ollama:/root/.ollama --name open-webui ghcr.io/open-webui/open-webui:ollamaDie persistenten Volumes bleiben erhalten, sodass alle eure Daten, Chats und Modelle auch nach dem Update verfügbar sind.

Rollback: Alles wieder entfernen

Falls ihr Open WebUI komplett entfernen möchtet, führt folgende Befehle aus:

Befehl:docker stop open-webui

Befehl:docker rm open-webui

Um auch das Container-Image zu entfernen:

Befehl: docker rmi ghcr.io/open-webui/open-webui:ollama

Um auch die persistenten Volumes zu entfernen (Achtung: Alle Chats, Einstellungen und Modelle gehen verloren!):

Befehl: docker volume rm open-webui open-webui-ollama

Wichtiger Hinweis: Das Entfernen der Volumes löscht alle eure Daten, Chats und heruntergeladenen Modelle. Stellt sicher, dass ihr wirklich alles entfernen möchtet, bevor ihr diese Befehle ausführt.

Zusammenfassung & Fazit

Die Installation von Open WebUI auf dem Gigabyte AI TOP ATOM ist dank Docker erstaunlich unkompliziert. In weniger als 20 Minuten habe ich eine vollständige Chat-Lösung laufen, die von jedem Computer im Netzwerk genutzt werden kann. Am meisten Zeit habe ich damit verbracht heraus zu finden das wohl auf der DGX Spark Plattform bei einem Docker pull nur ein Download laufen darf und nicht wie im Standard eingestellt 3 parallel laufen durfen. Nach dieser Anpassung wie oben beschrieben lief alles ohne Probleme.

Was mich besonders begeistert: Die Kombination aus Open WebUI und dem integrierten Ollama funktioniert nahtlos zusammen. Keine komplexe Konfiguration, keine API-Aufrufe einfach im Browser öffnen und chatten. Die GPU-Performance der Blackwell-Architektur wird voll ausgenutzt, und die Antworten kommen schnell und präzise.

Besonders praktisch finde ich auch die persistenten Volumes: Alle Chats, Einstellungen und Modelle bleiben erhalten, auch wenn der Container neu gestartet wird. Das macht die Verwaltung deutlich einfacher als bei einer manuellen Installation.

Für Teams oder Familien ist das eine perfekte Lösung: Ein zentraler Server mit voller GPU-Power, auf den alle über den Browser zugreifen können. Keine lokalen Installationen nötig, keine komplexen Konfigurationen – einfach die IP-Adresse im Browser öffnen und loslegen.

Falls ihr Fragen habt oder auf Probleme stoßt, schaut gerne in die offizielle NVIDIA DGX Spark Dokumentation, die Open WebUI Dokumentation oder in die Ollama Dokumentation. Die Community ist sehr hilfsbereit, und die meisten Probleme lassen sich schnell lösen.

Viel Erfolg beim Experimentieren mit Open WebUI auf eurem Gigabyte AI TOP ATOM – ich bin gespannt, welche spannenden Chats und Anwendungen ihr damit entwickelt!

Ein toller Guide der leicht zugänglich und verständlich ist. Perfekt für ein kleines Side-Project geeignet. Aktuell half mir noch mein…

Thank you for this great tutorial, could you share n8n workflow and comfyui workflow please?

Hallo Anton, die Meldung besagt das in meinem Beisiel Methoden verwendet werden die veraltet (deprecated) sind. Also müsstest Du die…

Danke für das Tool! Ich habe erst kürzlich angefangen mich mit der Thematik zu beschäftigen und bin für meine Erwartungen…

Hallo, ich habe ihre Anleitung befolgt und bekomme im letzten Schritt leider immer folgende Meldung im Terminal: bash <(wget -qO-…